Il existe déjà des dispositifs qui aident ces patients à composer des mots lettre par lettre, grâce à des mouvements des yeux ou de la tête. L’exemple le plus connu est sans doute celui de l’astrophysicien britannique Stephen Hawking, paralysé à cause d’une sclérose latérale amyotrophique (ou maladie de Charcot), qui parlait en contrôlant un logiciel à l’aide de sa joue. Mais bien qu’ils améliorent la qualité de vie, ces systèmes sont lents: ils produisent tout au plus 10 mots par minute, contre 150 en moyenne pour la parole.

Décoder les commandes cérébrales

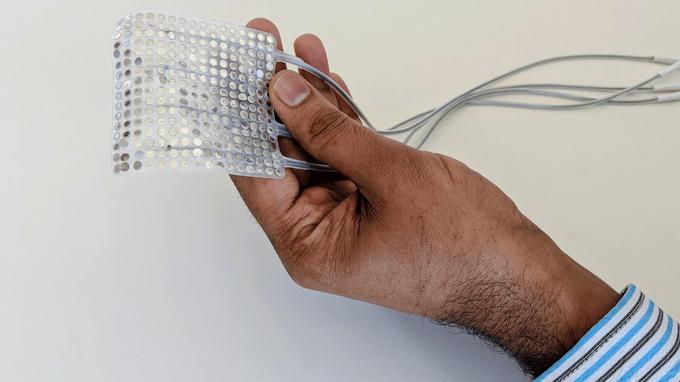

L’idée des chercheurs de l’UCSF a donc été d’aller puiser directement les mots à la source: dans le cerveau. Quand nous parlons, le cerveau envoie des signaux aux muscles du conduit vocal (lèvres, langue, larynx, mâchoire) afin de coordonner de façon fine et dynamique les mouvements qui permettront la production de sons. «Le cerveau traduit ce que vous voulez dire en mouvements, et c’est cela que nous essayons de décoder», explique Edward Chang, coauteur de l’étude et professeur de neurochirurgie à UCSF. Lui et ses collègues ont mis au point un système pour décoder ces commandes en utilisant des électrodes placées sur la partie du cerveau qui contrôle le mouvement.

Il ne s’agit donc pas d’une machine «magique» mais d’un procédé invasif complexe. Les scientifiques ont travaillé avec cinq patients épileptiques parfaitement capables de parler qui, dans le cadre de leur traitement, avaient des électrodes implantées de façon temporaire dans le cerveau. Ils ont d’abord demandé à ces personnes de lire à voix haute 100 phrases contenant tous les sons utilisés en anglais. En parallèle, ils ont enregistré l’activité des aires cérébrales qui contrôlent le langage grâce aux électrodes.

Une première mondiale

Pour reconstruire la parole synthétique de chaque participant, les chercheurs ont utilisé une approche de décodage en deux étapes: ils ont d’abord transformé les signaux neuronaux en représentations de mouvements du tractus vocal, avant de transformer ces mouvements en phrases parlées. Il ne s’agit donc pas de transformer des pensées abstraites en mots, mais bien de comprendre les instructions données par le cerveau aux muscles du visage et de déterminer, à partir de ceux-ci, quels mots ces mouvements formeraient. Les fichiers audio rendus publics par les scientifiques sont étonnants: si la voix synthétique mange certains mots, d’autres sont clairement compréhensibles, presque autant que dans la version naturelle des phrases étudiées.

«Pour la première fois, cette étude démontre que nous pouvons générer des phrases entières grâce à l’activité cérébrale d’un individu», a déclaré Edward Chang. «C’est une preuve de principe exaltante qu’avec une technologie déjà à notre portée, nous devrions être en mesure de construire un dispositif cliniquement viable pour les patients atteints de perte de la parole.»

Des obstacles techniques

Problème: cette méthode nécessite une grande quantité de données. Pour beaucoup de patients, il n’est plus possible de collecter ces données et pour les personnes en bonne santé, la méthode de collecte invasive (électrodes implantées dans le cerveau) rend la tâche inenvisageable. Mais selon Edward Chang, «les signaux cérébraux liés aux mouvements de la parole sont en partie communs à tous les individus. Il sera un jour possible qu’un décodeur paramétré sur un individu doué de la parole serve à un patient incapable de parler, qui pourra le contrôler grâce à sa propre activité cérébrale.»

La mise en application de cette technologie n’est donc pas pour demain. «Notre objectif à terme est de créer une technique permettant de restaurer la communication pour des patients incapables de parler, que ce soit en raison de problèmes neurologiques comme les AVC ou de maladies comme certains cancers», explique Edward Chang.